Text-to-Image o generador d'imatges és una tècnica d'intel·ligència artificial que permet generar imatges a partir de descripcions escrites en text utilitzant algoritmes d'aprenentatge automàtic.

Els avanços recents en la generació d'imatges basada en IA, encapçalats per models de difusió com Dalle-2, Midjourney i Stable Diffusion, han conquistat el món de la "generació d'art amb IA". Generar imatges d'alta qualitat a partir de descripcions de text és una tasca desafiadora.

Aquests models fan que sigui increïblement fàcil generar imatges d'alta qualitat en diversos estils utilitzant només unes poques paraules.

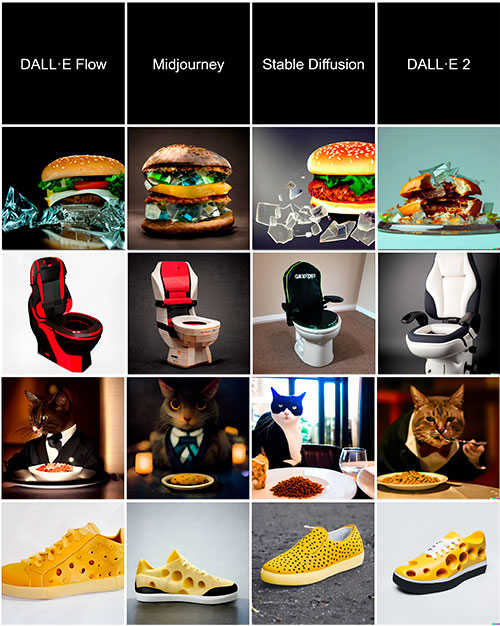

Podem veure una comparativa dels models generadors d'imatge més coneguts amb unes descripcions bàsiques per poder veure els resultats.

Descripcions:

Fila 1 -> Glass Burguer (Hamburguesa de vidre)

Fila 2 -> Gaming toilet (Sanitari Gaming)

Fila 3 -> Cat in a suite eating a plate of cat food at a fancy restaurant ( Gat en una suite menjant un plat de menjar per a gats en un restaurant sofisticat)

Fila 4 -> Sneaker inspired by Swiss cheese ( Sabatilla d'esport inspirat en el formatge suís)

Important a mencionar que cada model treballa de manera diferent a partir de les descripcions donades i que per obtenir els millors resultats cal conèixer les característiques de cada un. Nosaltres ens centrarem més en Stable Diffusion, perquè és l'únic que és Open Source, per tant, gratuït.

Crec important ressaltar que aquests models no són cercadors d'imatges, la imatge resultant és única i creada per la intel·ligència artificial, tot i que per crear-la s'ha basat en milions d'imatges que se li ha proporcionat per entrenar el model, ho detallem a continuació:

Per exemple Stable Diffussion va ser entrenat amb més de 5 mil milions d'imatges. Llavors podem pensar: "Si el model va veure 100.000 imatges de cavalls, aprendrà a dibuixar cavalls. Si va veure 100.000 imatges de la lluna, sabrà pintar la lluna. I si va aprendre de milers d'imatges d'astronautes, sabrà pintar astronautes". Però si li demanem que pinti "un astronauta a cavall a la lluna" què passa? La resposta és que el model que mai havia vist una imatge així, és capaç de generar centenars de variants d'imatges que compleixen amb el sol·licitat... això ja comença a ser increïble. Podem pensar: "Bé, estarà fent un collage, utilitzant un cavall que ja va veure, un astronauta (que també havia vist) i la lluna i fer una composició". I no; no és això el que fa, aquí es torna interessant: el model de Machine Learning parteix d'un "llenç en blanc" (en realitat és una imatge plena de soroll) i a partir d'aquí comença a generar la imatge, iterant i refinant el seu objectiu, però treballant en l'àmbit de píxel (per la qual cosa no està fent copiar-pegar). Si creguéssim que és una gran base de dades, els asseguro que no caben les 5.500.000.000 d'imatges en 4 Gigabytes -que són els pesos del model de la xarxa- perquè estaria emmagatzemant cada imatge (de 512 x 512px) en menys d'1 Byte, una cosa impossible.

DALL·E 3

DALL-E va ser revelat per OpenAI en una publicació de blog al gener de 2021 i utilitza una versió del model NPL GPT-3 modificat per a generar imatges. A l'abril de 2022, OpenAI va anunciar DALL-E 2, un successor dissenyat per a generar imatges més realistes a resolucions més altes que "poden combinar conceptes, atributs i estils".

MIDJOURNEY V6

MidJourney és el nom d'un laboratori independent que investiga la intel·ligència artificial. I també és el nom que li han posat a la seva IA. L'equip d'aquesta empresa està dirigit per David Holz, també hi ha noms com Jim Keller (enginyer de processadors d'Apple, AMD, Tesla, Intel i coautor de x86-64), Nat Friedman (CEO de Github i president de la Fundació GNOME) o Philip Rosedale (fundador de Second Life).

Cal destacar que a diferència dels altres models, MidJourney només es pot utilitzar mitjançant un bot en el Discord oficial del projecte.

STABLE DIFFUSION SDXL

Stable Diffusion és el nom d'un nou model de Machine Learning de Text-to-Image creat per Stability AI, Comp Vis i LAION. Entrenat amb +5 mil milions d'imatges del dataset Laion-5B en grandària 512 per 512 píxels. El seu codi va ser alliberat al públic el 22 d'Agost de 2022 i en un arxiu de 4GB amb els pesos entrenats d'una xarxa neuronal que podem descarregar des de HuggingFace, tenim el poder de crear imatges molt diverses a partir d'una entrada de text.

En ser un producte Open Source tenim moltes possibilitats en la seva utilització, ja que fins i tot podem descarregar el model i utilitzar el nostre ordinador (sempre que compleixi uns requisits mínims), realitzar reentrenaments del model, barrejar models, crear estils diferents i una llarga llista d'opcions que anirem enumerant amb exemples i videotutorials.

BING IMAGE CREATOR

Bing ha presentat "Bing Image Creator", que permet crear imatges a partir de paraules en el seu xat.

Funcions:

- Utilitza el model DALL-E avançat d'OpenAI per a generar imatges basades en l'entrada de text.

- La funció s'integrarà en el xat de Bing i Microsoft Edge, la qual cosa converteix a Edge en el primer navegador amb un generador d'imatges de IA incorporat.

- Microsoft s'adhereix als principis de IA responsable, implementant mesures de seguretat per a limitar la creació d'imatges nocives o insegures.

- Inicialment, la funció estarà disponible en anglès, i més endavant s'agregaran més idiomes.

Juntament amb aquesta increïble actualització, també llancen Stories, un resum visual impulsat per IA en el qual pots fer clic per a obtenir més informació sobre el tema que està buscant. A més de Knowledge Cards 2.0, una experiència inspirada en infografia impulsada per IA que brinda dades divertides i informació clau en segons.

Aquestes actualitzacions són significatives perquè és la primera vegada que les imatges generatives arribaran a les masses.

Computer vision és una branca de la intel·ligència artificial que se centra en el desenvolupament de sistemes computacionals que puguin analitzar, interpretar i comprendre imatges i vídeo. S'utilitza per a resoldre una àmplia gamma de problemes, incloent-hi la identificació d'objectes i persones en imatges, la detecció d'anomalies i la generació de descripcions d'imatges. L'objectiu de la computer vision és fer que les màquines tinguin la capacitat de "veure" i comprendre el món que els envolta, com el fan els éssers humans.

YOLO V8

L'algoritme You Only Look Onze (YOLO), és un sistema de codi obert per a detecció d'objectes en temps real, el qual fa ús d'una única xarxa neuronal convolucional per a detectar objectes en imatges. Per al seu funcionament, la xarxa neuronal divideix la imatge en regions, predient quadres d'identificació i probabilitats per cada regió; les caixes són ponderades a partir de les probabilitats predites. L'algoritme aprèn representacions generalitzables dels objectes, permetent un baix error de detecció per a entrades noves, diferents al conjunt de dades d'entrenament.

BLIP - 2

BLIP-2 és un nou marc de pre-capacitació per a la comprensió i generació unificades del llenguatge de visió, que aconsegueix resultats d'avantguarda en una àmplia gamma de tasques del llenguatge de visió.

En definitiva, aquest model és capaç de respondre qüestions que se li fan sobre una imatge, per exemple una imatge on surt la Sagrada Família, li podem preguntar quina ciutat és, i ens respondrà Barcelona.

La pre-capacitació del llenguatge de visió té com a objectiu utilitzar dades de text d'imatge per a ensenyar a un model la capacitat de comprendre conjuntament informació visual i textual.

FULL SELF DRIVING (FSD) - TESLA

Tesla és l'únic fabricant de vehicles elèctrics que desenvolupa la conducció autònoma, apostant completament per la Computer Vision en lloc d'un enfocament basat en LiDAR (sonar que utilitza ones làser per a traçar la distància entre objectes i construir mapes d'alta definició de la zona). Una simple analogia pot il·lustrar la diferència conceptual entre el Computer Vision i LiDAR. Imaginem dos estudiants, un dels quals es limita a "empollar" memoritzant el contingut (LiDAR), mentre que l'altre intenta comprendre realment l'entorn i aprendre'l de veritat (Tesla FSD). L'estudiant que va aprendre l'entorn (Tesla FSD) serà capaç de respondre a les preguntes de l'examen correctament, fins i tot si les preguntes de l'examen s'intercanvien, o si es reformulen, o s'afegeixen nous components a les preguntes, mentre que l'estudiant que va memoritzar el contingut (LiDAR) probablement suspendrà l'examen.

Lògicament, queden una infinitat de temes per tocar dins de la Imatge to Text i Computer Vision, a partir d'aquí continuarem indicant explicacions i novetat dins dels butlletins i si s'escau afegirem contingut en aquesta secció.